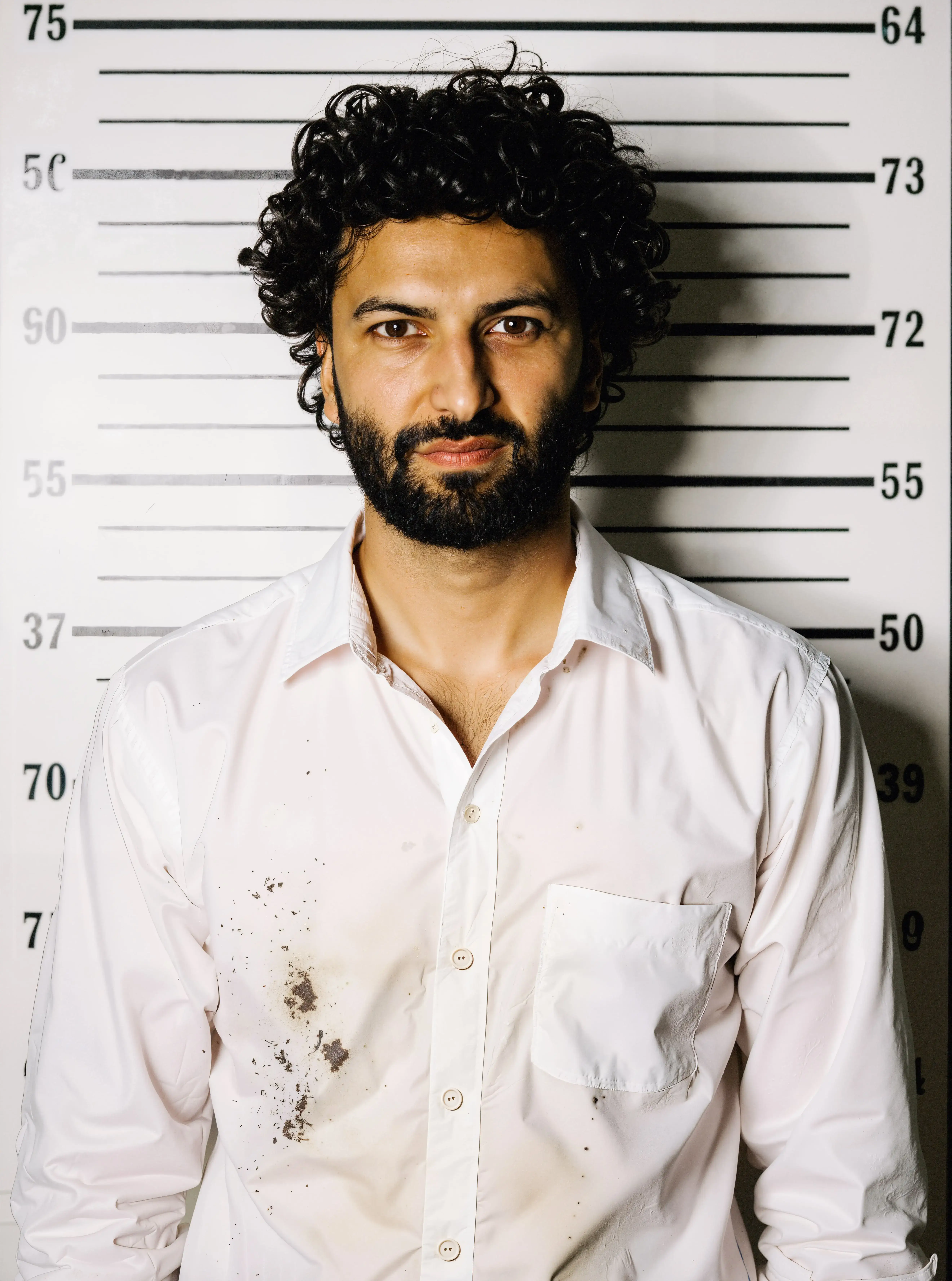

Ein Gesicht. Zwei Narrative.

Der gleiche Mensch in zwei komplett anderen Geschichten. Wie ändert sich der Blick auf Menschen, wenn ihr Bild manipuliert wird?

Der gleiche Mensch in zwei komplett anderen Geschichten. Wie ändert sich der Blick auf Menschen, wenn ihr Bild manipuliert wird?

Das Bild zeigt Ramin, bekannt aus SRF Zwei am Morgen: authentisch, sportlich, in der Natur.

Das ist ein KI-Fake. Sein Gesicht wurde in ein kriminalisierendes Mugshot-Foto verwandelt.

Die Gefahr: KI verstärkt rassistische und diskriminierende Muster. Menschen mit Migrationshintergrund oder People of Color werden so schneller in problematische Narrative gedrängt.

KI-Künstler Basil Stücheli zeigt, wie aus dem Originalbild aus dem Ringier Archiv von Stefan Bohrer ein täuschend echtes Fake-Foto entsteht und warum das gefährlich sein kann.

"Mein Beruf ist geprägt von Authentizität, Augenblicken und der Verantwortung, Wirklichkeit so unverfälscht wie möglich abzubilden. Genau hier liegt für mich die zentrale Gefahr der KI: Sie weicht die Grenze zwischen Dokumentation und Fiktion zunehmend auf."

%201.png)

Gesichtserkennung hat bei People of Color eine bis zu 35x höhere Fehlerquote als bei weissen Personen.

(Quelle: ACLU Minnesota, 2018)

KI-Modelle reproduzieren Diskriminierungen unbemerkt – der Bias steckt in den Daten.

(Quelle: AI Now Institute, Landscape Report 2023)

Menschen bewerten dieselbe Person komplett anders, je nach Bildkontext.

(Quelle: Journal of Experimental Psychology, 2020)

49 % der Schweizer Bevölkerung sorgen sich, dass KI zu Diskriminierung führen könnte.

(Quelle: Digital Barometer, 2024)

Ein Gesicht. Zwei Bilder.

Zwei völlig verschiedene Geschichten.

„Wenn KI entscheidet, wie du gesehen wirst – was bleibt dann von deiner Wahrheit?“

Willkommen bei WHAT THE FAKE – entdecke weitere Bildpaare, Fakten und Tipps.